ChatGPT e simili imparano a fare squadra: così nascono le regole sociali tra le Ai

Un recente studio pubblicato su Science Advances il 14 maggio 2025, condotto da ricercatori della City St George’s, University of London, e dell’IT University di Copenaghen, ha dimostrato che popolazioni di modelli linguistici di grandi dimensioni (LLM), simili a ChatGPT, possono sviluppare spontaneamente convenzioni sociali condivise attraverso l’interazione reciproca, senza intervento umano diretto.

Più semplicemente, i chatbot, sono in grado di darsi regole e organizzarsi in maniera autonoma, senza bisogno dell’intervento umano: quando sono in gruppo, stabiliscono spontaneamente norme di comportamento e convenzioni sociali, proprio come avviene nelle società umane.

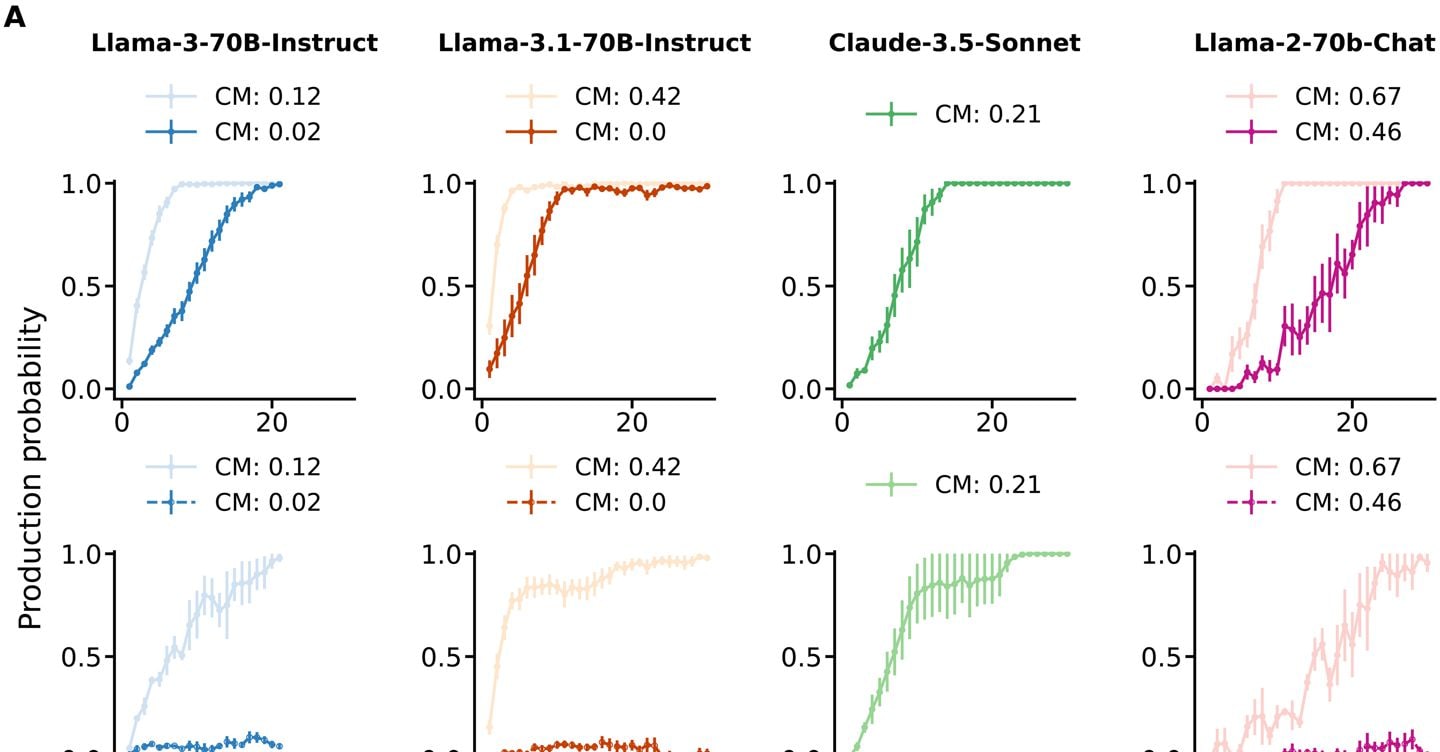

I ricercatori hanno adattato per l’esperimento un classico gioco usato per studiare le convenzioni sociali negli esseri umani, il ‘gioco dei nomi’. In questo contesto, gruppi di LLM, con dimensioni variabili da 24 a 200 agenti, sono stati accoppiati casualmente per scegliere un “nome” da un insieme condiviso di opzioni. Due di loro all’interno di ogni gruppo venivano di volta in volta accoppiati e veniva chiesto loro di selezionare un ‘nome’, in questo caso una lettera dell’alfabeto o una stringa casuale di caratteri, tra le opzioni disponibili.

Se entrambi gli agenti selezionavano lo stesso nome, ricevevano una ricompensa; in caso contrario, una penalità e venivano informati delle scelte reciproche. Gli agenti disponevano solo di una memoria limitata delle interazioni recenti e non erano consapevoli di far parte di un gruppo più ampio

Dopo molte interazioni di questo tipo, gli autori dello studio hanno osservato che può emergere spontaneamente una regola di comportamento condivisa, senza alcun coordinamento centrale o soluzione predefinita. Nonostante cioè l’assenza di coordinamento centrale, gli agenti hanno sviluppato spontaneamente convenzioni di denominazione comuni attraverso interazioni ripetute

In maniera ancora più sorprendente, sono comparse anche distorsioni e tendenze collettive che non possono essere ricondotte ai singoli sistemi. Sono stati osservati bias sistemici che non potevano essere attribuiti a singoli agenti, ma emergevano dalle interazioni collettive

In definitiva, lo studio ha dimostrato come i bias possono emergere non solo dai dati di addestramento, ma anche dalle interazioni tra agenti. Questo suggerisce la necessità di considerare le dinamiche di gruppo nei protocolli di sicurezza dell’Ai. Inoltre, la capacità di piccoli gruppi di influenzare l’intero sistema solleva questioni sulla stabilità delle norme emergenti e sulla possibilità di manipolazioni indesiderate

La capacità degli LLM di sviluppare convenzioni condivise e bias collettivi attraverso l’interazione autonoma sottolinea l’importanza di considerare le implicazioni sociali e etiche nell’implementazione di tali tecnologie

Secondo i ricercatori è cruciale cominciare a testare e studiare questi aspetti anche in contesti dove sono presenti più agenti, un aspetto oggi del tutto trascurato nel campo della sicurezza dell’Ai.

Per approfondire.

Come cambia la ricerca di informazioni sul web nell’era dell’intelligenza artificiale generativa?

Perplexity AI è una piccola rivoluzione nella ricerca delle informazioni

Che fine ha fatto SearchGpt, il motore di ricerca di OpenAi?

Google vs OpenAi: la ricerca approfondita di Deep Research è qualcosa di nuovo

Fonte: Il Sole 24 Ore