Come usare Llama 3 (l’AI di Meta) sul proprio computer e perché farlo

È possibile usare un modello di intelligenza artificiale sul proprio computer senza bisogno di essere ingegneri informatici. Basta un computer non troppo lento per cominciare a “giocare” un po’ con i modelli disponibili per un uso locale. E uno dei migliori è Llama 3, appena pubblicato gratis da Meta.

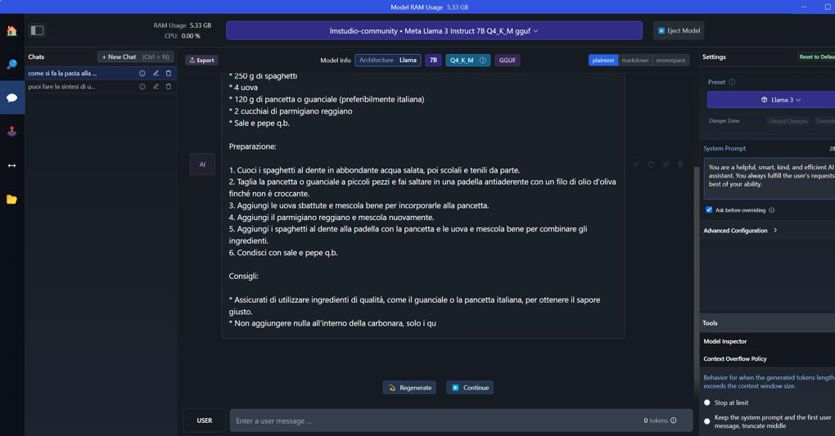

Possiamo lanciarlo su Lm Studio, programma gratuito e abbastanza facile da usare, tanto che simula l’interfaccia grafica di un chabot tipico, con i prompt.

Perché usare l’IA sul proprio computer

Mettere un modello sul proprio computer invece che usarlo in cloud – come siamo stati abituati finora con i chatbot da Chatgpt in poi – è un’esperienza da fare se abbiamo una passione per la tecnologia e un piglio da smanettoni. E se vogliamo capire un po’ meglio come funzionano questi modelli e quali adottare. “È anche una strada obbligata se vogliamo inserire nel prompt dati personali, segreti industriali o altre informazioni che vogliamo restino al sicuro sul nostro computer, invece che farli arrivare all’azienda che offre il servizio”, spiega Antonio Cisternino, responsabile informatico presso l’università di Pisa e creatore del framework open Sybilla basato su intelligenza artificiale https://www.ilsole24ore.com/art/ia-l-universita-pisa-lancia-sibylla-l-assistenza-online-non-conosce-piu-frontiere-AFeGgPq.

Quale Llama 3 scegliere

Di base bisogna sapere che Llama è una famiglia di modelli IA, linguistici di grandi dimensioni (LLM) pre-addestrati e tarati sulle istruzioni, con parametri di 8B e 70B. Su Lm Studio troviamo queste due versioni, a loro volta suddivise in sotto alternative a seconda del numero di istruzioni presenti. Questi modelli sono stati addestrati su oltre 15 trilioni di token di dati, un set di dati di addestramento sette volte più grande di quello utilizzato per i modelli Llama 2, con un numero di codice quattro volte superiore, che supporta una lunghezza di contesto (ossia la memoria di informazioni che possiamo dargli) fino a un valore 8K.Ufficialmente, Llama 3 8B va bene nella sintesi del testo, nella classificazione del testo, nell’analisi del sentiment in un testo e nella traduzione linguistica. Llama 3 70B, oltre che per quanto sopra, è pensato per la creazione di contenuti, l’intelligenza artificiale conversazionale, la comprensione del linguaggio, lo sviluppo della ricerca e le applicazioni aziendali. È più bravo del 7B nella sintesi e nell’accuratezza del testo, nella classificazione e nelle sfumature del testo, nell’analisi del sentimento e nel ragionamento sulle sfumature, nella modellazione del linguaggio, nei sistemi di dialogo, nella generazione di codice e nel seguire le istruzioni. Meta sta inoltre addestrando altri modelli Llama 3 di dimensioni superiori a 400B parametri. Questi modelli da 400B avranno nuove funzionalità, tra cui la multimodalità, il supporto di più lingue e una finestra di contesto molto più lunga. Una volta rilasciati, questi modelli saranno ideali per la creazione di contenuti, l’intelligenza artificiale conversazionale, la comprensione del linguaggio, la ricerca e sviluppo e le applicazioni aziendali.

Come usare Llama 3 su Lm Studio

Usare Llama 3 sul proprio computer ha senso anche perché questo modello non è ancora disponibile in Italia tramite il canale Meta ufficiale www.meta.ai. Negli Usa è già integrato nei vari prodotti Meta come Facebook e Whatsapp.Ci sono vari modi per un uso locale e un programmatore tenderà a preferire il software Ollama, a riga di comando, ma come si diceva Lm Studio ha un’interfaccia più familiare all’utente comune.Dopo l’installazione scriviamo Llama 3 nella barra di Home o nella search (lente di ingrandimento nel menu a sinistra). Qui apparirà un’ampia scelta di file tra cui scegliere. Per orientarci tra queste diverse versioni (di Llama o altri modelli) bisogna qui conoscere il concetto di “quantizzazione”, un insieme di tecniche che consentono di eseguire modelli su piattaforme con risorse limitate. Come appunto il nostro computer o addirittura uno smartphone. Immaginiamolo come una specie di livello di compressione della musica. Più è alto, più è agevole farci stare e usare quel modello. Ma la qualità scende.La scelta del livello di quantizzazione “migliore” comporta in genere vari compromessi tra dimensione del file, qualità e prestazioni. I “numeri di bit” di quantizzazione più alti (Q4 bit o più) in genere preservano una maggiore qualità, mentre i livelli più bassi comprimono ulteriormente il modello, il che può portare a una perdita significativa di qualità. Come suggerisce Lm Studio, “scegliete un livello di quantizzazione che sia in linea con le capacità del vostro hardware e che soddisfi le esigenze di prestazioni della vostra attività. Se non si è sicuri di quale opzione scegliere, si consiglia di sperimentarne alcune diverse ed eseguire una propria valutazione”.Con l’opzione Compatibility guess attivata dovremmo vedere solo i file compatibili con il nostro hardware. Proviamo a installare il 70 B e il 7 B nella quantizzazione maggiore tra le opzioni compatibili (almeno 4 Q). Poi clicchiamo sulla nuvola a sinistra (la chat) e nel menu a tendina in alto selezioniamo il modello da caricare.Poi cominciamo a fare domande e richieste, come faremmo con il Chatgpt gratuito (versione 3.5). Teniamo conto che la conoscenza del 7 B si ferma a marzo 2023 e quella del 70 B a dicembre 2023; e non hanno collegamento a internet se usati localmente.Abbiamo usato un gaming pc entry level (500-600 euro) e anche il modello 7 B è (molto) più lento del Chatgpt gratuito e ci è sembrato anche un po’ meno accurato e dettagliato nelle risposte, di cultura generale, o richieste di sintesi di testo. “Gtp 3.5 è più evoluto e comunque Chatgpt ottimizza il nostro prompt per migliori risultati”, spiega Cisternino. Ma usare l’IA sul proprio pc ha vantaggi e dà un’esperienza (e conoscenza) non paragonabile con il “solito” Chatgpt che tutti conoscono.

Fonte: Il Sole 24 Ore