Gruppi di lavoro misti, liberi da stereotipi di genere

«Una società col baco genera software bacati». Guido Scorza, avvocato esperto di nuove tecnologie e componente dell’Autorità garante per la protezione dei dati personali, sintetizza così il rischio che l’intelligenza artificiale riproduca e amplifichi pregiudizi e stereotipi, a partire da quelli di genere. Un pericolo che vede elevato innanzitutto «negli algoritmi applicati alla selezione del personale, perché è facile che i prescreening, sempre più diffusi, prediligeranno per alcuni ruoli i curricula maschili, scartando a priori quelli femminili».

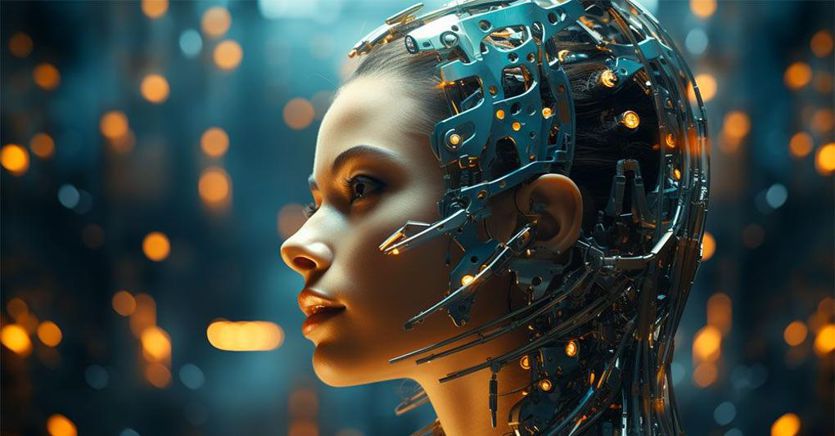

I bias “professionali” preoccupano anche Emanuela Girardi, fondatrice e presidente di Pop AI (Popular Artificial Intelligence) e alla guida di Adra, l’Associazione europea su AI, Data e Robotics che lavora con la Commissione Ue sul piano di investimenti Horizon Europe 2021-2027. «I modelli di intelligenza artificiale generativa, i più popolari e i più utilizzati dal pubblico generale – spiega – sono addestrati sullo scibile che esiste su Internet, dunque pieni di potenziali discriminazioni. Riproponendo il contenuto in modo matematico-statistico, non fanno altro che amplificare ciò che è presente nella nostra società. Ecco perché se chiedo di generare l’immagine di un medico o di un manager, sarà un uomo bianco di mezza età. Se chiedo un infermiere, sarà una donna, probabilmente più giovane».

Il meccanismo è infido: l’immaginario collettivo preesistente colonizza l’immaginario AI, che a sua volta lo rinforza. «Rischiamo di ritrovarci nei contenuti, compresi video e foto, tutte le note discriminazioni basate sul genere», afferma Scorza. Un salto all’indietro paradossale, che potrebbe spazzare via le conquiste degli ultimi decenni. Ma le conseguenze potrebbero essere persino più gravi. Girardi segnala i sistemi utilizzati in campo medico. Un esempio? «Sappiamo che i sintomi dell’infarto sono molto diversi tra uomini e donne. Ma la maggior parte dei sistemi di AI viene addestrata sul corpo umano maschile, con il risultato che se una donna si presentasse in un ospedale dove per il triage è utilizzato un sistema simile i suoi sintomi potrebbero non essere riconosciuti. Tutti i sistemi che prendono decisioni in modo automatico in ambiti sensibili potrebbero aumentare le disuguaglianze».

Dove si annida il corto circuito? Scorza e Girardi concordano: bisogna guardare alla fonte, ai gruppi di lavoro che producono gli algoritmi. «Negli Stati Uniti sono composti prevalentemente da uomini e questo influenza le scelte nello sviluppo dei prodotti», osserva l’esperta. «Va un po’ meglio in Europa, soprattutto nei Paesi nordici, ma in ogni caso non si sfora quasi mai il 20% di presenza delle donne». Aumentare quella quota si deve. Promuovendo le lauree Stem tra le studentesse, certo, ma per Girardi «servirebbero anche più role model. Negli anni Novanta c’erano le serie Tv sulle avvocate, poi quelle sui medici. Oggi occorrerebbe incoronare protagoniste le donne del tech».

Nuovi immaginari per curare vecchi immaginari stereotipati. «I media hanno una grande responsabilità – sottolinea Scorza – che è anche quella di offrire una narrativa equilibrata sugli algoritmi, che non sia polarizzata tra catastrofisti ed entusiasti ma informi correttamente su vantaggi e pericoli». Necessaria insieme al lavoro a monte per individuare prima i potenziali bias. «L’AI Act europeo – dice il giurista – introduce la valutazione d’impatto di ogni soluzione algoritmica per garantirne la sostenibilità in termini etici». Ma c’è anche la strada degli interventi a valle. «Si può fare con i dati sintetici, bilanciando il dataset se non è completo o se produce bias», sostiene Girardi. «Un sistema che al 90% genera uomini bianchi di mezza età può essere corretto».

Fonte: Il Sole 24 Ore