La traduzione in tempo reale sbarca su smartphone, occhiali e meeting. Voce e identità salve (quasi)

Una chiamata di lavoro o una video conferenza in lingua straniera; un viaggio all’estero: sono esperienze più facili adesso, per chi non conosce bene l’idioma dell’interlocutore. Grazie alle traduzioni in tempo reale fatte dall’intelligenza artificiale. Già: si può dire che l’AI ha più o meno abbattuto questa barriera linguistica, anche se c’è strada da fare ancora per la perfezione. E la buona notizia è che l’italiano (traduzioni a/dalla nostra lingua) è ampiamente supportato.

È significativo che tutte le big tech siano in campo, ormai: Meta, Apple, Google, Samsung, Microsoft. Vedi Google, che con il nuovo Pixel 10 ha introdotto “Voice Translate”: una funzione che traduce le telefonate tra l’inglese e dieci altre lingue mantenendo la voce originale dell’utente (il timbro e in teoria anche le espressioni o emozioni, anche se su questo è ancora fallace). L’operazione avviene “on device”, grazie al chip Tensor G5 e ai modelli AI Gemini Nano, quindi con meno latenza e proteggendo la privacy. In pratica, l’interlocutore sente la voce del chiamante, ma nella propria lingua.

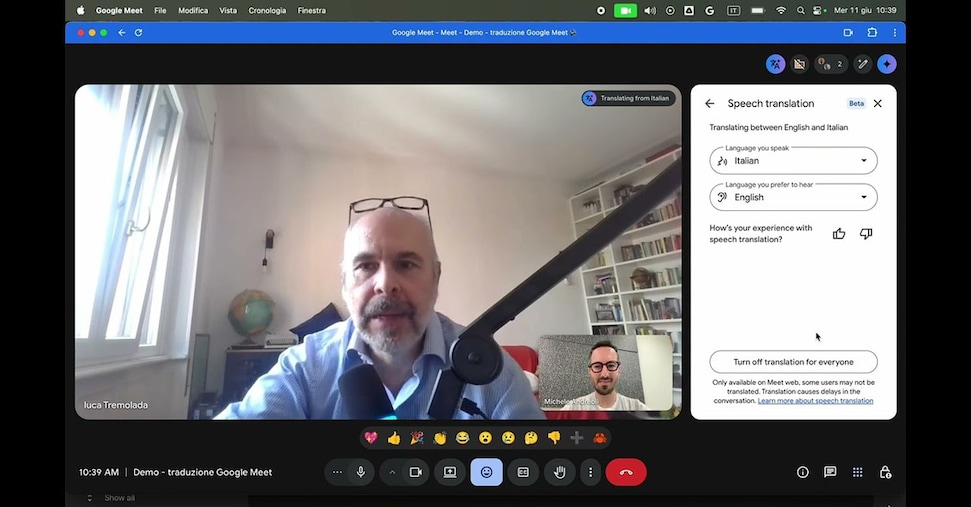

È un passo tecnologico importante: la voce “mimica” preserva (più o meno) l’identità comunicativa. La stessa tecnologia è estesa Google Meet, per videoconferenze di lavoro.

Anche Apple si muove nella stessa direzione, ma con un approccio diverso: centrato sulle esperienze “dal vivo”. Con l’ultima versione di iOS, la funzione Live Translation arriva sugli auricolari AirPods, qui permettendo di tradurre in tempo reale conversazioni in persona. L’utente può attivare la modalità con un gesto o con Siri, e ascoltare la traduzione direttamente negli auricolari mentre parla con qualcuno che usa un’altra lingua. Il tutto, ancora una volta, con computazione locale per tutelare la privacy. È un esempio di come Apple punti a rendere invisibile la tecnologia, trasformando una funzione complessa in un gesto naturale.

Un’altra visione di futuro ancora ce l’ha Meta, che ha portato la traduzione vocale fuori dallo smartphone, dentro gli occhiali Ray-Ban (di seconda generazione). Qui l’assistente AI integrato è in grado di tradurre ciò che l’utente ascolta o dice, restituendo la traduzione tramite gli altoparlanti incorporati. Meta crede insomma in un orizzonte in cui la realtà aumentata ci libererà dagli schermi; servirà non solo a mostrare informazioni visive, ma anche a mediare linguisticamente il mondo reale. Google sta già seguendo la stessa strada con i suoi progetti per occhiali basati su Android XR.

Fonte: Il Sole 24 Ore