Parli come ChatGpt. Così l’intelligenza artificiale ci rende più gentili ma più diffidenti

Sono passati meno di tre anni dal debutto di ChatGPT, e l’intelligenza artificiale ha già iniziato a cambiare non solo il nostro modo di lavorare e studiare, ma anche quello di parlare. Nel senso linguistico del termine. Lo dice uno studio del Max Planck Institute for Human Development che ha analizzato quasi 280 mila video postati su YouTube da canali accademici. Risultato? Da quando il chatbot di OpenAI è entrato nelle nostre vite, anche il nostro modo di parlare si è «modellizzato». Cosa vuole dire? Ci sono parole che iniziamo a usare senza accorgercene. Entrano piano nel nostro lessico, si insinuano nei discorsi quotidiani, fanno capolino nei video, nei post, nei podcast. Ma cosa succede se quelle parole vengono da un’intelligenza artificiale? Alcune parole — tipo «approfondire», «meticoloso», «regno» ed «esperto» — sono diventate molto più frequenti. Fino al 51% in più rispetto a tre anni fa. Ma non è un caso: secondo uno studio precedente della Stanford University, queste sono esattamente le espressioni preferite da ChatGPT. E ora sembrano diventare anche le nostre. Hiromu Yakura, primo autore dello studio, la mette giù così: «Stiamo interiorizzando un vocabolario virtuale», spiega. In altre parole: stiamo iniziando a parlare come l’IA che ci parla ogni giorno. Tradotto: non siamo solo noi a insegnare alle macchine a parlare come gli umani. È iniziato il movimento inverso. Il linguaggio dell’IA ci «plasma», e non solo nel testo scritto. L’oralità — soprattutto quella più ragionata, come nei video didattici e accademici — sta assorbendo, parola dopo parola, il lessico delle grandi IA. Il cambiamento è misurabile, non solo in quantità ma anche in qualità. L’analisi ha infatti confrontato l’andamento di parole tipiche del linguaggio GPT con termini simili ma meno associati all’intelligenza artificiale, notando che solo le prime sono aumentate in modo marcato dopo il lancio di ChatGPT, il 30 novembre 2022. Non solo: in oltre la metà dei casi, le parole «GPT-like» non venivano lette da un copione, ma pronunciate spontaneamente. Una parola, su tutte, emerge come filigrana linguistica del nuovo vocabolario generativo: «approfondire». Levin Brinkmann, co-autore dello studio, lo chiama un marcatore invisibile, una specie di watermark semantico. Se la senti spuntare in una conversazione, magari non ci pensi, ma forse c’è l’ombra lunga di ChatGPT dietro. Le conseguenze?

L’Ai sta cambiando anche il nostro modo di pensare

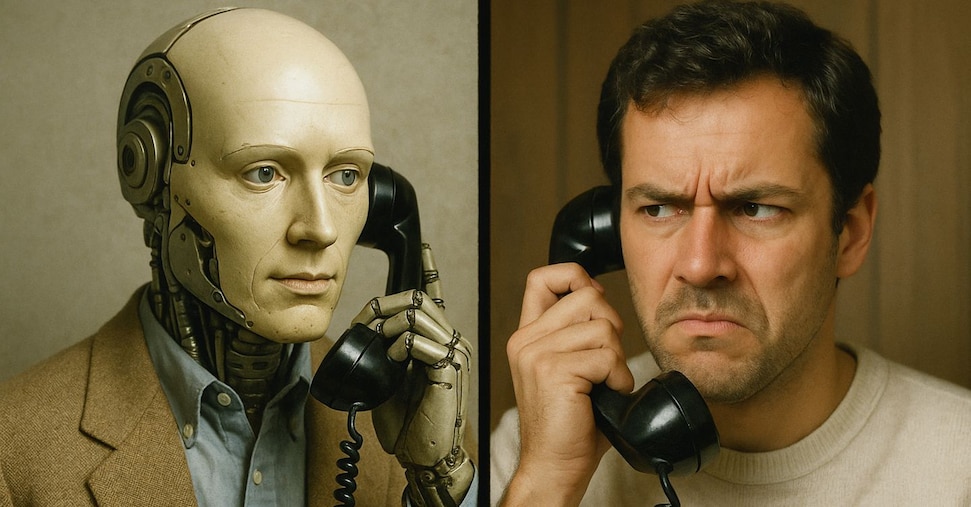

Una ricerca della Cornell University ha analizza il nostro utilizzo di risposte intelligenti nelle chat. In pratica hanno condotto due esperimenti controllati su circa 1.000 partecipanti, utilizzando suggerimenti automatici di brevi risposte testuali generate da un’intelligenza artificiale durante una conversazione via chat, email o messaggistica. Hanno scoperto che l’uso dell’Ai rende le chat più rapide, più emozionalmente positive, e chi la utilizza viene giudicato più collaborativo. Tuttavia, se le persone credono che il loro partner stia utilizzando l’intelligenza artificiale nell’interazione, lo valutano come meno collaborativo e più esigente. Fondamentalmente, non era l’effettivo utilizzo dell’intelligenza artificiale a scoraggiarli, ma il sospetto che la utilizzassero. Possiamo definirlo il paradosso della comunicazione aumentata. In pratica, più il messaggio è perfetto, più ci sembra sospetto. E non importa se il nostro interlocutore abbia davvero usato un’Ai o meno. Basta il sospetto per alterare la percezione che abbiamo di lui: lo giudichiamo meno autentico, meno coinvolto, più «meccanico». Non è l’uso reale dell’intelligenza artificiale a raffreddare i rapporti — è il linguaggio stesso che, quando sembra artificiale, ci allontana. Lo spiega bene Malte Jung, professore associato alla Cornell e coautore dello studio, che dichiara a The Verge: «Formiamo le nostre impressioni basandoci su segnali linguistici. E quando quei segnali sembrano artificiali, si rompe qualcosa nella relazione». In pratica, è come se il nostro cervello attivasse un allarme: «Questa frase non è sua, non è vera». Il pensiero va a Blade Runner e ai sistemi per individuare i replicanti. Secondo i ricercatori, si possono già individuare dei segnali per capire se dall’altra parte c’è un umano o una macchina. Più la comunicazione è sporca, goffa e ironica, e più è umana. Prendiamo due frasi: «Mi dispiace che tu sia arrabbiato» e «Scusa, mi sono agitato a cena, probabilmente non avrei dovuto saltare la terapia questa settimana». La prima è funzionale e fredda. L’altra è imperfetta ma viva. La conseguenza è quella di un cambiamento più profondo. Per Naaman, il vero rischio non è l’uso dell’Ai in sé, ma la perdita della nostra capacità di pensare con parole nostre. «Invece di articolare ciò che pensiamo, ci limitiamo ad articolare ciò che il chatbot ci suggerisce. E così diventiamo più persuasi, più passivi». E se questo schema si diffonde, il sospetto cresce. Ci si fida solo della comunicazione faccia a faccia. Non più delle chat, nemmeno delle videochiamate. Perché è solo nel corpo, nel tono, nella spontaneità che si riconosce un essere umano. Il resto — anche se più efficiente — comincia a sembrarci troppo levigato, troppo perfetto. Troppo simile a una macchina.

Fonte: Il Sole 24 Ore