Nasce MGIE, un modello AI open-source per modificare le immagini con il linguaggio naturale

Ricercatori di Apple e l’Università della California hanno pubblicato MGIE, un nuovo modello AI open-source che permette di modificare le immagini sulla base di istruzioni in linguaggio naturale fornite dall’utente nel prompt. Il modello Ai è stato presentato alla International Conference on Learning Representations (ICLR) 2024, la conferenza di ricerca sull’intelligenza artificiale tra le più importanti al mondo.

Cos’è MGIE e cosa promette

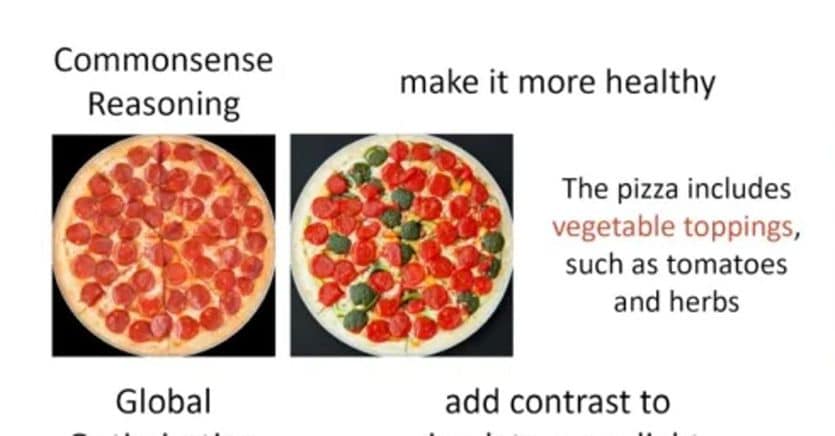

MGIE, acronimo di MLLM-Guided Image Editing, è in grado di gestire in maniera intuitiva vari aspetti dell’editing, come la modifica in stile Photoshop, l’ottimizzazione delle foto e modifiche localizzate. In particolare, MGIE utilizza il modello linguistico multimodale LLaVA, sviluppato nel processo di modifica delle immagini. Secondo gli sviluppatori, nel paper viene spiegato che alcuni di loro hanno lavorato al progetto durante un il vantaggio di MGIE è quello di democratizzare la correzione di immagini con una facilità di editing imparagonabile ai tradizionali software, che richiedono competenze tecniche e manualità specifiche. Inoltre, il modello è in grado di generare risultati di alta qualità e di fornire spiegazioni delle modifiche effettuate, aumentando la trasparenza e la fiducia degli utenti.Il suo ambito di applicazione è piuttosto vasto: può essere usato per migliorare le foto, creare collage, trasformare le immagini in stili diversi, aggiungere elementi creativi, insegnare i principi dell’editing di immagini e molto altro. Il modello può anche essere integrato con altre piattaforme e servizi, come le app di messaggistica, i social media, i siti web e i dispositivi intelligenti.

Come funziona MGIE

Per usare MGIE, è sufficiente scaricare il codice sorgente dal repository GitHub e seguire le istruzioni per installare le dipendenze e avviare il modello. MGIE è compatibile con Python 3.8 e richiede una GPU NVIDIA con almeno 16 GB di memoria.Una volta avviato MGIE è in grado di fornire un’immagine di input e un prompt di testo per modificare l’immagine. Il modello restituirà un’immagine di output modificata secondo le istruzioni, insieme a una spiegazione delle operazioni effettuate. Il modello supporta anche una modalità interattiva, in cui è possibile fornire più prompt di testo per modificare ulteriormente l’immagine di output. Ad esempio: dato il prompt: “Rendere il cielo più blu e aggiungere una nuvola a forma di cuore”, il modello restituisce l’immagine e il seguente spiegazione: “Ho aumentato la saturazione della zona cielo del 20% e ho aggiunto una nuvola a forma di cuore usando il modello di generazione di immagini Ganilla”.

Fonte: Il Sole 24 Ore