Phi-3 Microsoft lancia Phi-3 un nuovo modello di Ai generativa leggero

Occorre una premessa. Le prestazioni dei modelli di intelligenza artificiale sono direttamente influenzate dalla quantità, ma anche dalla qualità e dalla messa a punto dei loro parametri, che se ben adattati possono migliorare significativamente l’accuratezza, l’efficienza e affidabilità dei sistemi di Ai. In pratica i parametri sono le istruzioni complesse che un modello è in grado di comprendere e alcuni LLM già rilasciati ne contano centinaia di miliardi, come GPT3, che al momento del rilascio ne contava ben 175 miliardi.

Quanti miliardi di parametri servono?

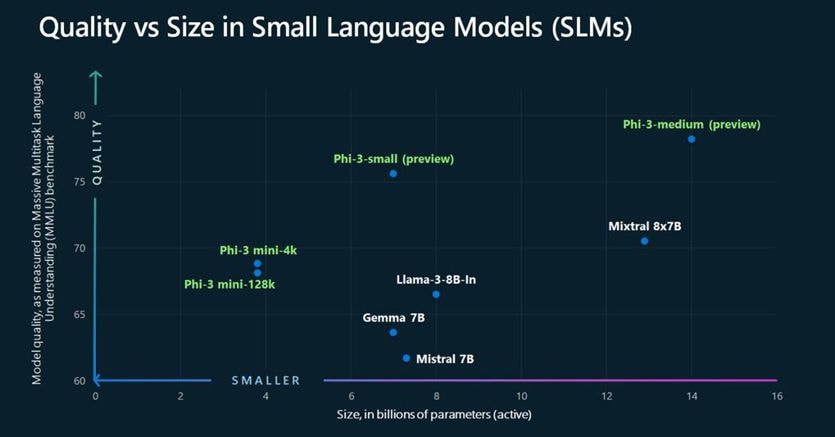

Partendo dalla necessità di creare un modello linguistico dalle dimensioni ridotte, più snello e meno legato ad hardware complessi su cloud, i ricercatori si sono chiesti quanti parametri sono davvero necessari per costruire un modello che offra un ragionamento di senso comune e la risposta sembra essere arrivata con la nuova famiglia di modelli linguistici di piccole dimensioni Phi-3. Si parte con Phi-3-mini (il primo di una serie di tre small language model a cui seguiranno a breve Phi-3 Small, con 7 miliardi di parametri e Phi-3 Medium con 14 miliardi), che anche se addestrato su un set di dati notevolmente più piccolo rispetto ai modelli linguistici di grandi dimensioni, è in grado di eguagliare le capacità di altri LLM ben più potenti. Eric Boyd, vicepresidente della Azure AI platform di Microsoft, ha dichiarato a The Verge che Phi-3 Mini ha le stesse capacità di Gpt-3.5 “solo in un formato più piccolo”, garantendo però un costo di gestione inferiore e la possibilità di funzionare al meglio anche su dispositivi meno potenti come smartphone e laptop. Il team di ingegneri del colosso guidato da Satya Nadella – che a dicembre aveva presentato Phi-2 – sostiene che di aver adottato un nuovo approccio più efficiente e intelligente all’Ai, con uno dei migliori rapporti costo-prestazioni di qualsiasi altro modello sul mercato, superando modelli di dimensioni fino a 10 volte superiori. Per ottenere questo gli sviluppatori al posto di farcire l’Ai con milioni di dati pescati dalla rete, hanno addestrato Phi-3 ispirandosi al modo in cui i bambini imparano dalle favole della buonanotte, ovvero mediante parole e frasi dalla struttura più semplice che parlano di argomenti di ampio respiro. “Non ci sono abbastanza libri per bambini in circolazione, quindi abbiamo preso un elenco di oltre 3.000 parole e abbiamo chiesto a un LLM di creare ’libri per bambini’ per addestrare Phi”, afferma Boyd. Oltre a tutte le altre fasi legate alla Responsible AI che vengono adottate prima di rilasciare un modello, l’addestramento che sfrutta i dati sintetici ha permesso a Microsoft di aggiungere un ulteriore livello di sicurezza e di ridurre i problemi più comuni legati all’uso di un linguaggio dannoso come quello che spesso viene mostrato dai modelli addestrati su dati provenienti da Internet.

Quello che promette Phi3-mini.

IL’obiettivo del nuovo Sml di Microsoft è quello di fornire risposte basate su conoscenze generali, offrendo un netto miglioramento nella capacità di risoluzione dei problemi e un livello di ragionamento superiore. Il vantaggio di Phi-3 Mini è che è abbastanza compatto da essere eseguito localmente su uno smartphone, ma riesce comunque a competere con modelli più grandi, anche senza la necessità di una connessione a Internet o di un accesso al cloud, ampliando l’accesso all’intelligenza artificiale in luoghi privi delle infrastrutture necessarie per sfruttare gli LLM. Una dimostrazione concreta che anche i modelli di lingua più piccoli possono trovare il loro spazio, soprattutto per applicazioni con risorse limitate. Grazie alla minore necessità di calcolo, sono più convenienti, soprattutto per quelle aziende che non possono permettersi di avere LLM in cloud. Microsoft ha reso Phi-3 disponibile su HuggingFace, Ollama e Azure, consentendo di eseguire il modello localmente.

Fonte: Il Sole 24 Ore

-U88741851134fYY-1440x752@IlSole24Ore-Web.jpg?r=1170x507)

-kw7E-U66780276612Msr-1440x752@IlSole24Ore-Web.jpg?r=1170x507)